Розгортаємо DeepSeek на власному сервері в кілька кліків

DeepSeek AI — це потужна відкрита модель ШІ, яка може працювати без використання GPU. У поєднанні з Ollama вона дозволяє запускати ШІ локально з повним контролем над продуктивністю та конфіденційністю.

Розміщення DeepSeek на власному сервері забезпечує високий рівень безпеки, усуваючи ризик перехоплення даних через API. Офіційні сервери DeepSeek дуже часто перевантажені. Локальне розгортання дозволяє використовувати тільки власні ресурси ШІ, не ділячись ними з іншими користувачами.

Зверніть увагу, що DeepSeek є стороннім програмним продуктом. Компанія SpaceCore Solution LTD. не несе відповідальності за роботу цього програмного забезпечення.

Які характеристики потрібні?

Порівняємо моделі з різними вимогами. Кожна модель може працювати як на CPU, так і на GPU. Однак, оскільки ми використовуємо сервер, у статті розглядається встановлення та робота моделі саме на ресурсах процесора.

| Версія моделі | Розмір | Оперативна пам’ять | Рекомендований тариф | Можливості |

|---|---|---|---|---|

| deepseek-r1:1.5b | 1.1 GB | 4 GB | Hi-CPU Galaxy | Прості завдання, ідеально підходить для тестування та пробних запусків. |

| deepseek-r1:7b | 4.7 GB | 10 GB | Hi-CPU Orion | Написання та переклад текстів. Розробка нескладного коду. |

| deepseek-r1:14b | 9 GB | 20 GB | Hi-CPU Pulsar | Розширені можливості для розробки та копірайтингу. Чудовий баланс швидкості й функціоналу. |

| deepseek-r1:32b | 19 GB | 40 GB | Hi-CPU Infinity | Потужність, порівнянна з ChatGPT o1 mini. Поглиблений аналіз даних. |

| deepseek-r1:70b | 42 GB | 85 GB | Мінімальний виділений сервер | Обчислення високого рівня для бізнес-завдань. Глибокий аналіз даних та комплексна розробка. |

| deepseek-r1:671b | 720 GB | 768 GB | Потужний виділений сервер на замовлення | Основна й найпросунутіша модель DeepSeek R1. Надає обчислювальні можливості на рівні останніх моделей ChatGPT. Рекомендуємо розміщувати на потужному виділеному сервері з NVMe-дисками. |

Встановлення DeepSeek 14B

Ми встановимо модель 14B як приклад, оскільки вона забезпечує високу продуктивність за помірного споживання ресурсів. Інструкція підходить для будь-якої з доступних моделей, і за потреби ви можете встановити іншу версію.

Оновіть репозиторії та системні пакети до останньої версії.

sudo apt update && sudo apt upgrade -y

Встановіть Ollama — менеджер програм, необхідний для розгортання DeepSeek.

curl -fsSL https://ollama.com/install.sh | sh && sudo systemctl start ollama

Після завершення встановлення виконайте команду для завантаження потрібної моделі DeepSeek.

ollama pull deepseek-r1:14bВстановлення цієї моделі займе приблизно 2 хвилини на сервері Hi-CPU Pulsar завдяки високій швидкості мережі. Далі виконайте команду для запуску моделі DeepSeek.

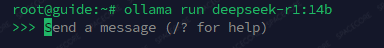

ollama run deepseek-r1:14b

З’явиться командний рядок для введення повідомлень. Чудово — тепер ви можете спілкуватися з ШІ!

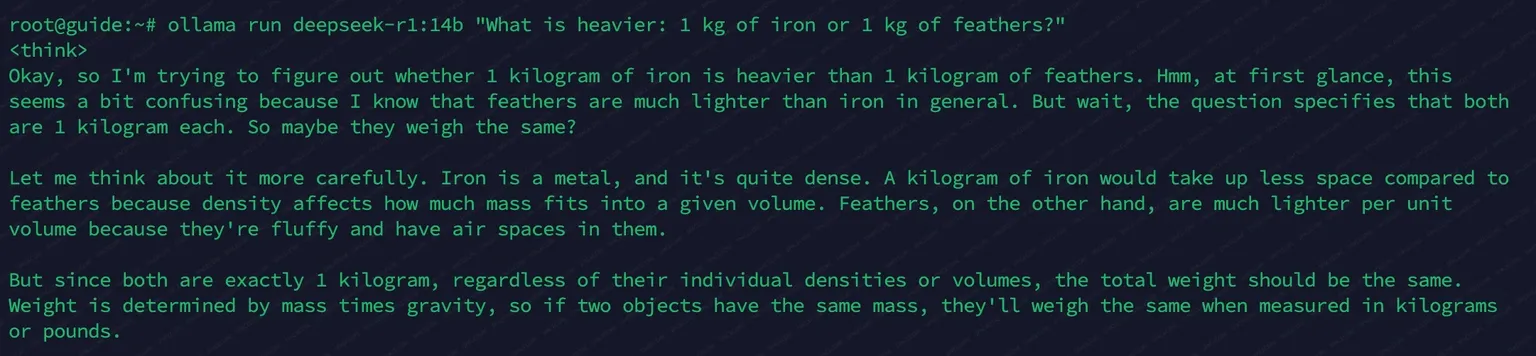

Також можна відправити одноразову команду, наприклад:

ollama run deepseek-r1:14b "Що важче: 1 кг заліза чи 1 кг пір'я?"

Для генерації публічного ключа та доступу по API виконайте команду:

ollama serve

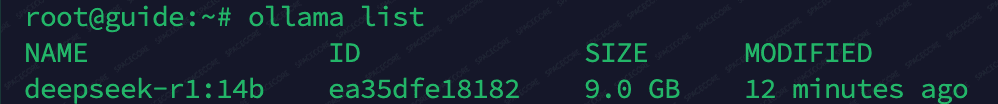

Щоб перевірити встановлені моделі та їхній статус, виконайте команду:

ollama list

Висновок

Ми рекомендуємо розміщувати моделі DeepSeek R1 на серверах із достатнім обсягом оперативної пам’яті. Для стабільної роботи моделей бажано орендувати сервери з невеликим запасом ОЗП, а також швидкими NVMe-дисками.

Тарифи, наведені в таблиці, ідеально підходять для розміщення ШІ DeepSeek. Ми гарантуємо якість серверів SpaceCore. Довірте нам розміщення вашого сервера та побудуйте інфраструктуру для надійного й зручного використання DeepSeek у вашому бізнесі.